Von Grit Wolany. Bild: Deep Mind via Unsplash

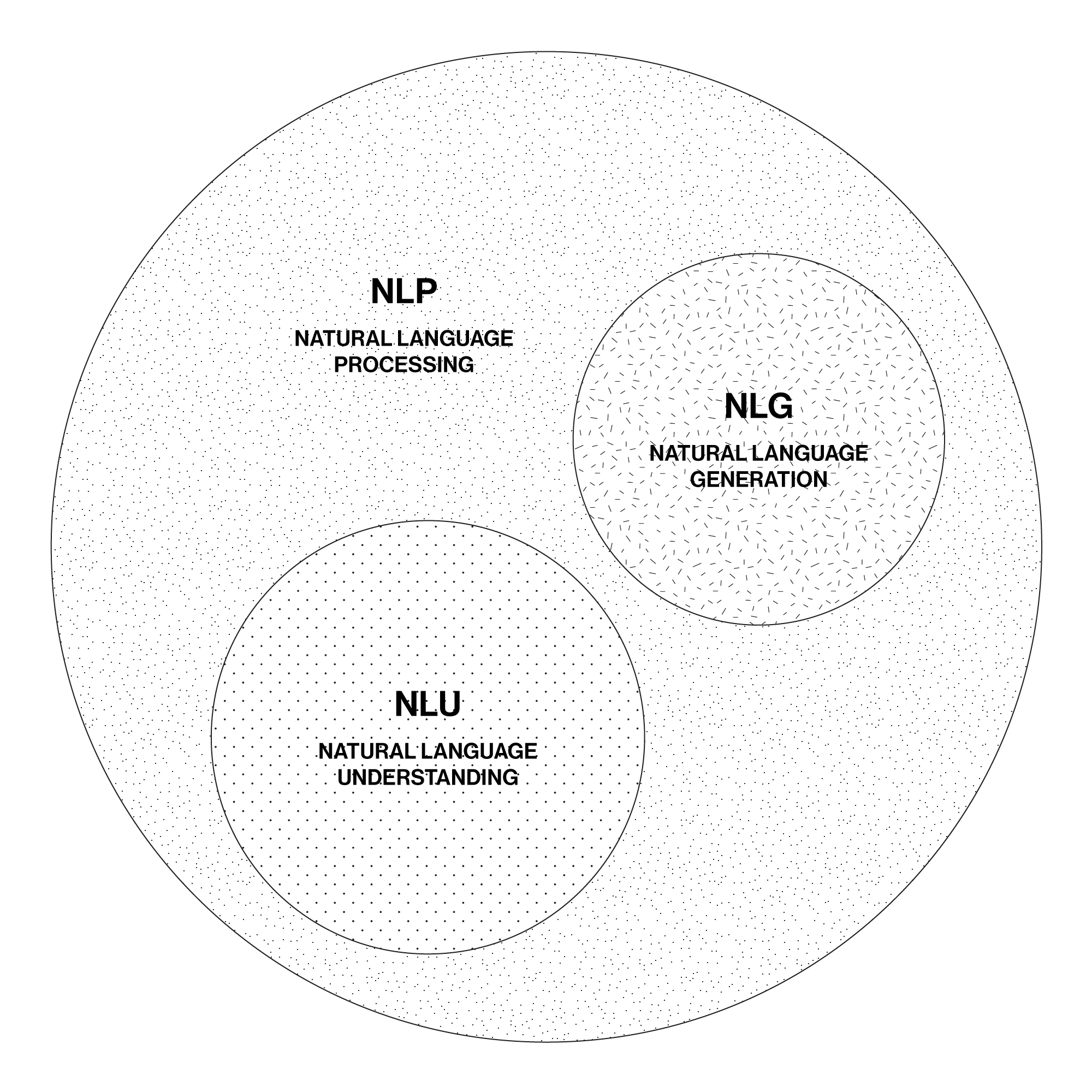

Das Gebiet der Natürlichen Sprachverarbeitung (NLP) umfasst die Natürliche Spracherkennung (NLU) sowie die Natürliche Sprachgenerierung (NLG).

Kurz gesagt: 1. «Verstehen», was gesprochen oder geschrieben wird und 2. «Antworten», also Text oder Sprache erzeugen.

GPT-3

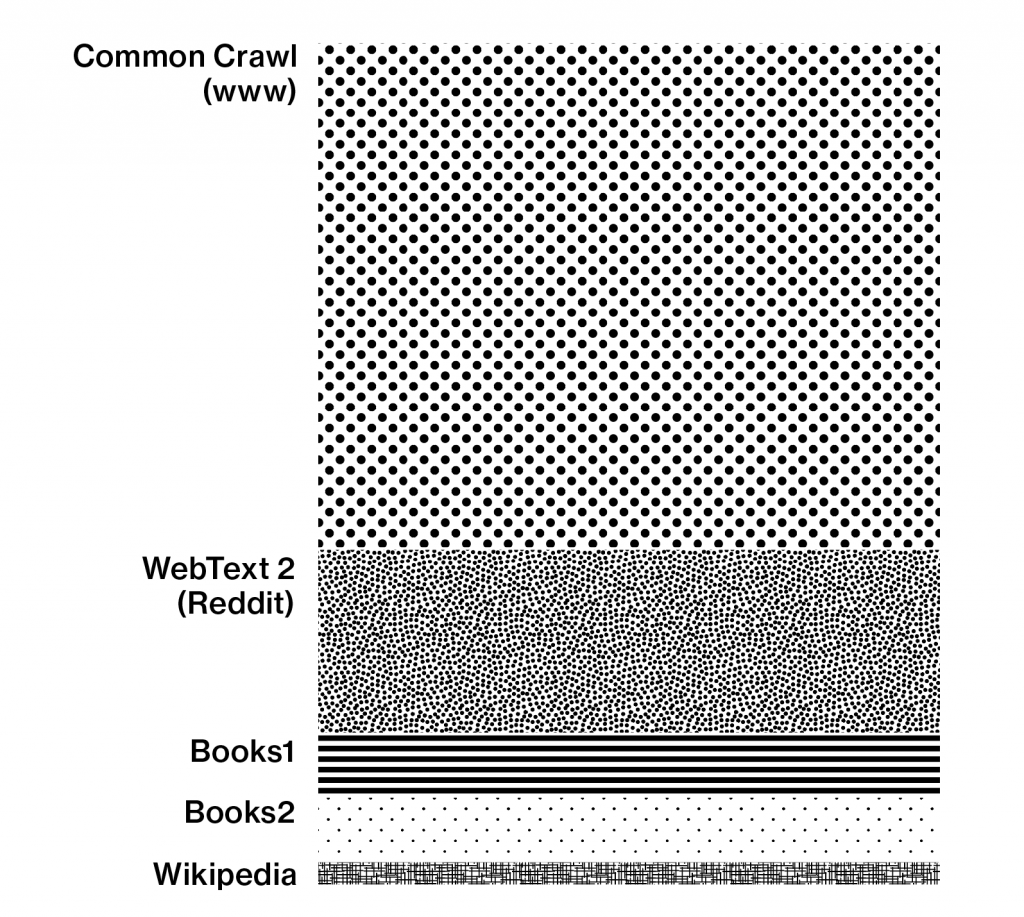

Die Text-KI GPT-3 (Generative Pre-trained Transformer 3) ist ein auf Deep Learning basierendes Sprachmodel der Research Organisation Open AI aus dem Jahr 2020, welches vorab mit grossen Textmengen trainiert wurde.

Diese Trainingsdaten waren meist in Englisch, deshalb sind die KI-Ausgabeergebnisse in Englisch am besten.

GPT-3 steckt mittlerweile in vielen Anwendungen. Einige texterzeugende KI-Tools stellen wir euch in diesem Blog-Beitrag vor.

Wie Maschinen lesen

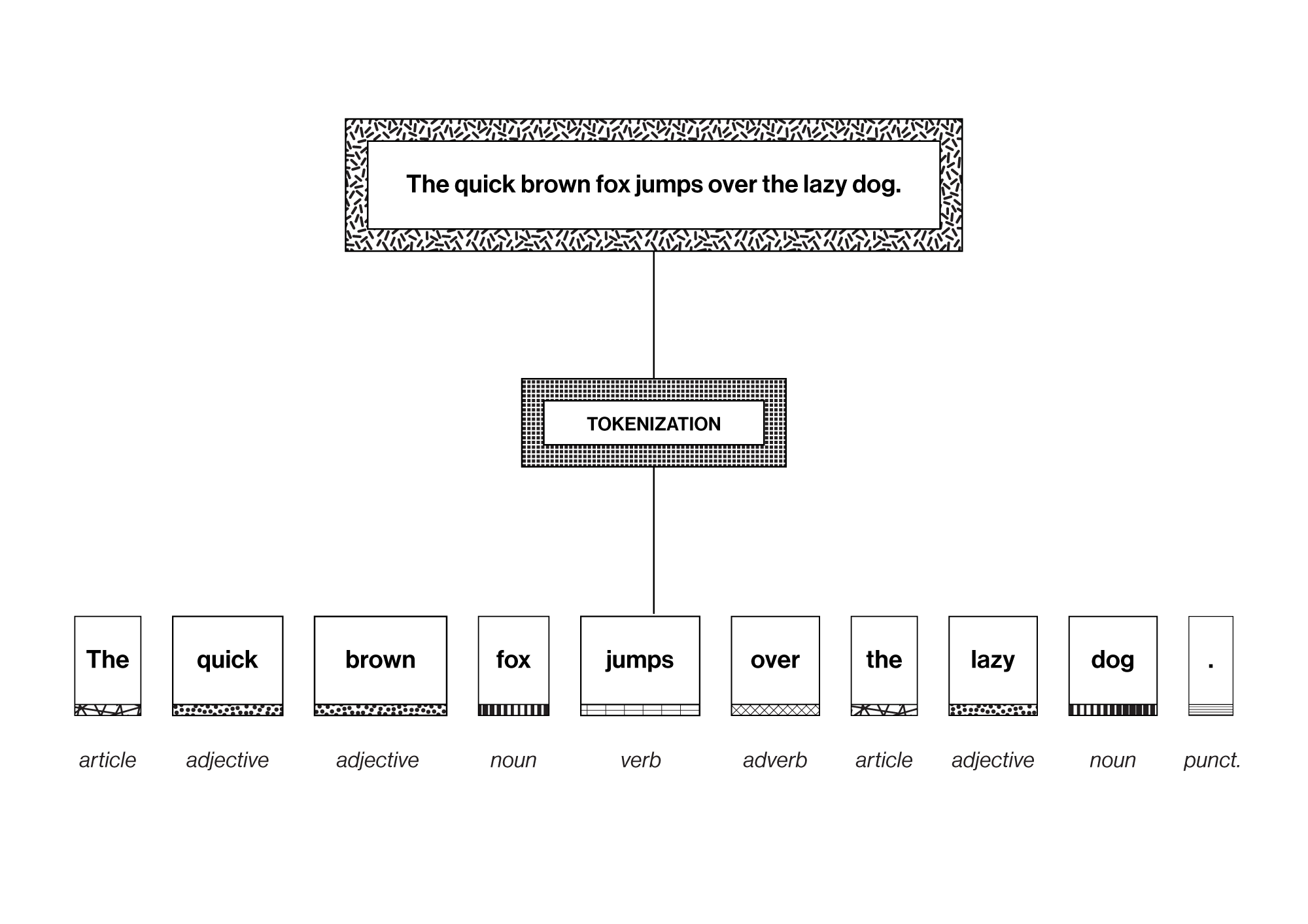

Beim Natural Language Processing (NLP) werden Texte in einzelne Token unterteilt, die je nach ihren statisch-linguistischen Verhältnismässigkeiten in numerische Werte übersetzt und so algorithmisch weiterverarbeitet werden können.

Wer noch genauer wissen will, wie das Ganze funktioniert, der schaut das verlinkte Video. Hier erklärt Laurence Moroney vom Google AI Team das Thema sehr verständlich und anschaulich.

Diese Tokenisierung sorgt also dafür, dass aus Worten Nummern werden, mit denen Maschinen arbeiten können. Und dies ist die Basis für eine Vielzahl von Machine Learning Anwendungen.

Grit Wolany absolvierte an der ZHdK das Masterstudium Design, Trends & Identity und forschte zum Thema Künstliche Intelligenz in der Kreativwirtschaft.