Workshop & Text: Grit Wolany Bild: Midjourney AI

Im Dezember veranstaltete das Digital Skills & Spaces Team einen Workshop zu bildgenerierender KI. Für alle, die den Termin verpasst haben, oder das Gelernte nochmal auffrischen wollen, gibt es hier eine ausführliche Zusammenfassung.

Das Thema Bild KI ist hochaktuell und wird kontrovers diskutiert. Viele rechtliche und ethische Frage bezüglich Copyright oder der Verwendung von Trainingsdaten ohne expliziter Zustimmung der Urheber sind noch ungeklärt. Während die einen schon die neue kreative Renaissance bejubeln, wollen andere KI am liebsten verbieten.

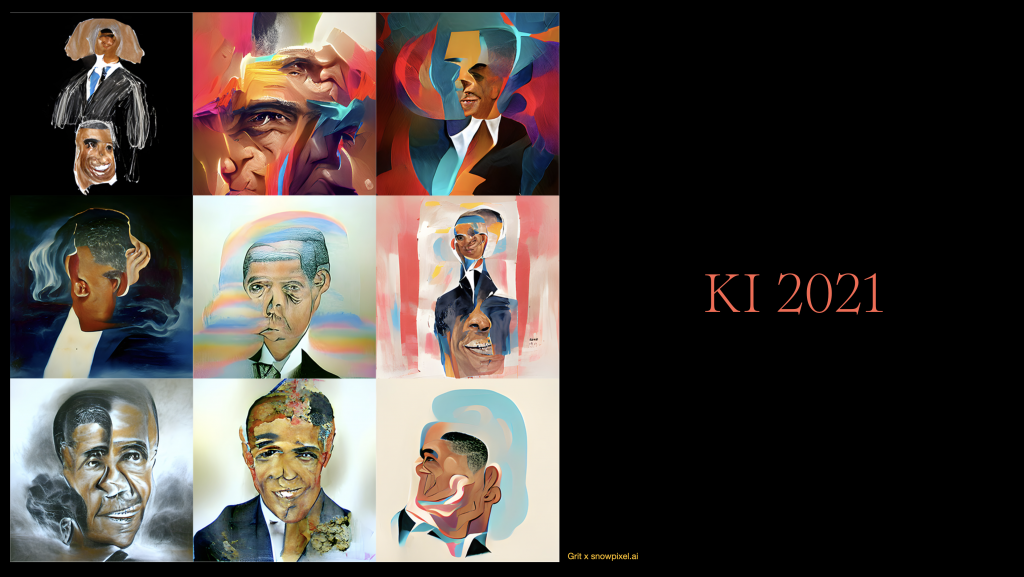

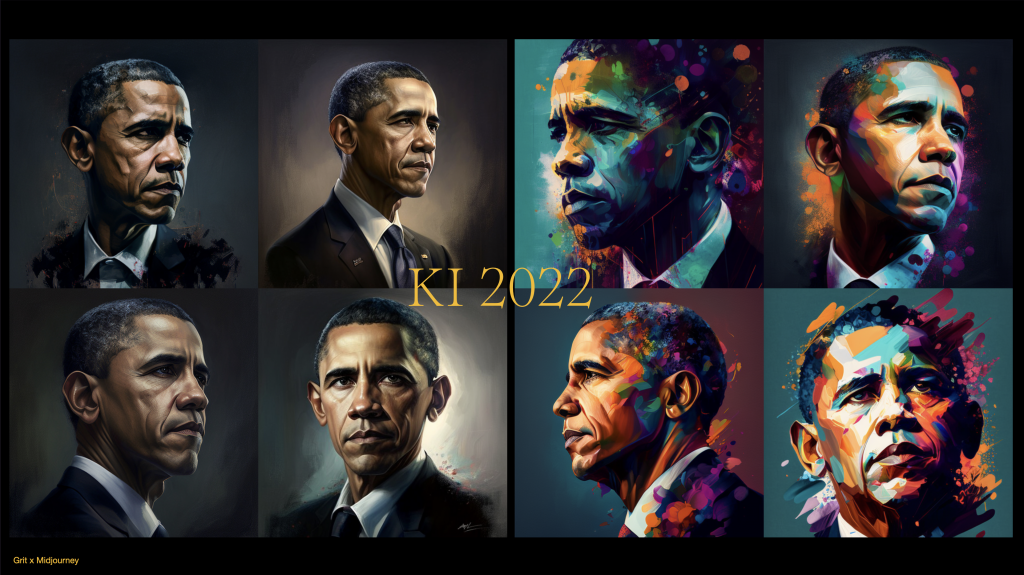

Aber der Reihe nach. Zunächst können wir feststellen, dass sich KI-Technologien in einem rasanten Tempo entwickeln. Ob Text-, Bild- oder Soundgenerierung – fast jeden Tag gibt es neue Erfolgsmeldungen. War Barack Obama im KI-generierten Portrait von 2021 nur mit viel gutem Willen erkennbar, so sind die Ergebnisse aus dem Herbst 2022 im Vergleich dazu ein Quantensprung.

Willkommen im Latent Space

Egal ob man kreativen KI-Tools positiv oder eher ablehnend gegenübersteht – man sollte zumindest wissen, wie die Basistechnologie der bildgenerierenden Algorithmen funktioniert.

Das unten verlinkte Video der US News-Website Vox.com erklärt den Prozess anschaulich und sehr gut nachvollziehbar. ((Wer’s ganz eilig hat, kann auch direkt zu Minute 6:00 des Videos springen und erfahren, was es mit dem Begriff des multidimensionalen „Latent Space“ auf sich hat und wie aus Daten und Textinputs genau Bilder entstehen.))

Am populärsten sind zur Zeit folgende Bild KI-Modelle:

Dall-E 2

Dall-E 2 ist das Bildgenerierungsmodell von OpenAI, einem der grössten KI-Forschungsunternehmen der Welt. OpenAI entwickelte auch die beliebte Text-KI GPT3, welche in letzter Zeit mit der neuen Anwendung Chat GPT für Furore sorgte. Bei der Anmeldung erhält man im ersten Monat 50 gratis Credits. Jeden weiteren Monat gibt’s 15 weitere Free Credits dazu. Will man mehr Bilder generieren, kann man für $15 weitere 115 Credits kaufen.

Dall-E kann nicht nur komplett neue Bilder generieren, sondern mit Hilfe der Inpainting Technik markierte Bereiche eines hochgeladenen Bildes ersetzen oder neue Bildteile ansetzen.

Midjourney AI

Midjourney, ein kleines unabhängiges Research Lab, wurde 2020 gegründet und befindet sich seit Juli 2022 in einer Open Beta Version. Das bedeutet, der Zugang zur Software ist offen zugänglich. Midjourney positionierte sich von Anfang an als Tool für Kreative und bietet deshalb im Vergleich zu den anderen Anbietern mehr Möglichkeiten zu kreativer Nutzung, Intervention und Art Direction.

Die Nutzung von Midjourney erfolgt via Discord, ihr braucht also zunächst einen Account bei Discord. Newbies können 25 Bilder gratis generieren. Für die weitere Nutzung muss ein Monatsabo für $10 gelöst werden, mit dem man weitere 200 Bilder generieren kann.

Stable Diffusion

Im Gegensatz zu den beiden vorherigen Modellen, die auf Cloud Services beruhen, verfolgt Stable Diffusion einen Open Source Ansatz. Das KI-Modell wurde in Zusammenarbeit von Stability AI, CompVis der Ludwig-Maximilians-Universität München und Runway entwickelt und von EleutherAI und LAION unterstützt.

Während Dall-E 2 und Midjourney sich betreffs der verwendeten Trainingsdaten bedeckt halten, setzt Stable Diffusion auf Transparenz. Als Basisdataset diente das „2b English Language Label Subset“ des LAION 5b Sets, welches sich aus „Common Crawl“-Daten des Internets zusammensetzt. Bisher gab es für die LAION 5b-Modelldaten keine Möglichkeit eines Opt-Ins oder Opt-Outs, da diese bewusst unkuratiert für Research angelegt wurden. Es bildet also zunächst eine allgemeine Darstellung der Verbindung zwischen Sprache und Bild im öffentlich zugänglichen Internet ab und sollte ganz einfach den Status Quo aufzeigen.

Mit der zunehmenden breiten sowie kommerziellen Nutzung dieser Daten für Text-to-Image KI-Anwendungen entstehen völlig neue rechtliche und ethische Fragen, die uns auch in Zukunft noch lange beschäftigen werden. Die Diskussion ist spannend und hochemotional, würde aber den Rahmen dieses Workshops sprengen.

Es besteht die Möglichkeit, Stable Diffusion mit eigenen Bildern zu trainieren und so Modelle mit konkreten Stilen zu entwickeln. Hier und hier gibt es mehr Informationen dazu. Noch ist das ein recht technischer Prozess; es gibt aber bereits Firmen wie bspw. Scenario.gg, die bereits an einfach zu bedienenden Lösungen arbeiten.

Erste Schritte mit Midjourney

Nach diesen grundsätzlichen Basics ging es endlich los. In den Midjourney Discord Newbie Channels experimentierten wir mit Text, Text-Bild-Prompts und verschiedenen Parametern.

Achtung Newbies, beim ersten Prompt bekommt ihr eine Meldung, in der ihr einmalig die Midjourney Terms Of Service (ToS) akzeptieren müsst, bevor es richtig losgeht.

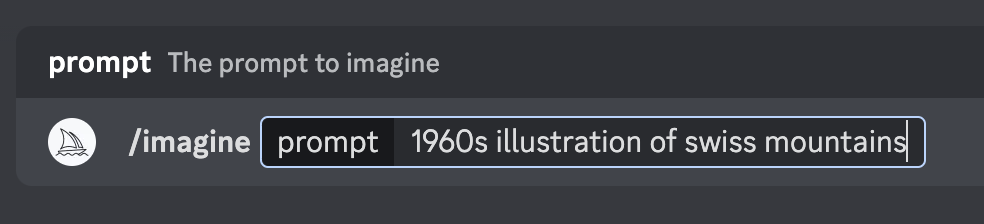

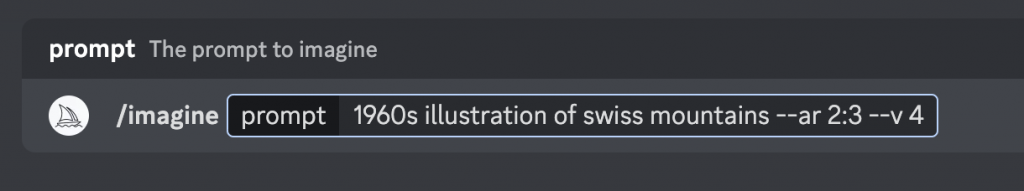

Das wichtigste Midjourney-Kommando lautet

/imagine

Danach kann man den Prompt, also quasi das Briefing für die AI formulieren. Da die KI Modelle mit englischen Daten trainiert wurden, sollten auch die Prompts in Englisch erfolgen.

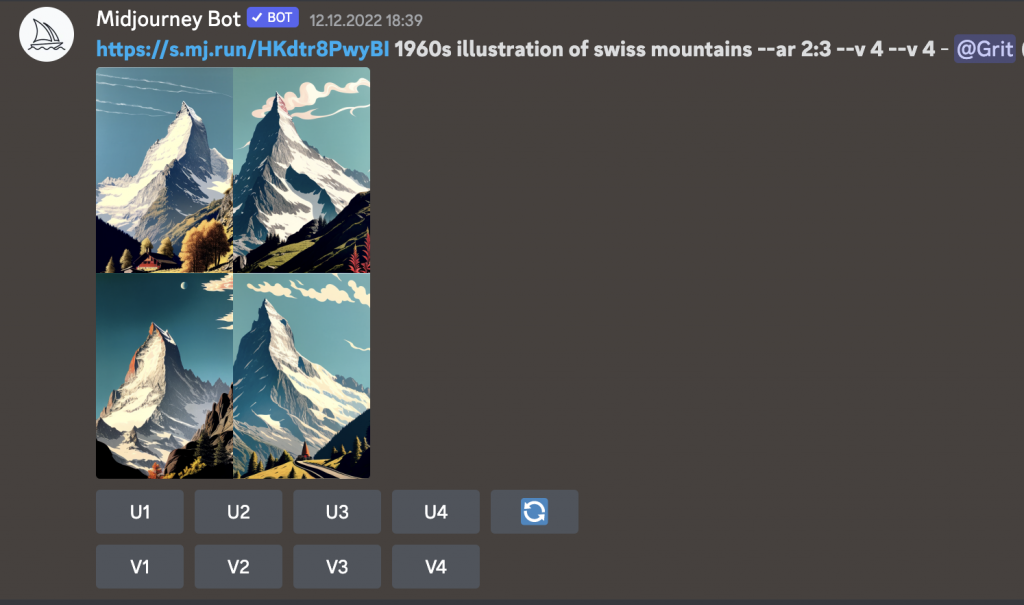

/imagine[ 1960 illustration of swiss mountains ]

Schon nach kurzer Zeit, erhält man das Ergebnis – ein Raster mit 4 generierten Bildvorschlägen. Diese können dann vergrössert werden oder auf Basis eines generierten Bildes neue Vorschläge erstellt werden.

Mit den U und V Buttons kann entschieden werden, wie die KI weiter vorgehen soll.

U steht für Upscaling, also Vergrösserung. V steht für Variantionen. U2 vergössert also das Vorschaubild oben links.

Pro-Tipp:

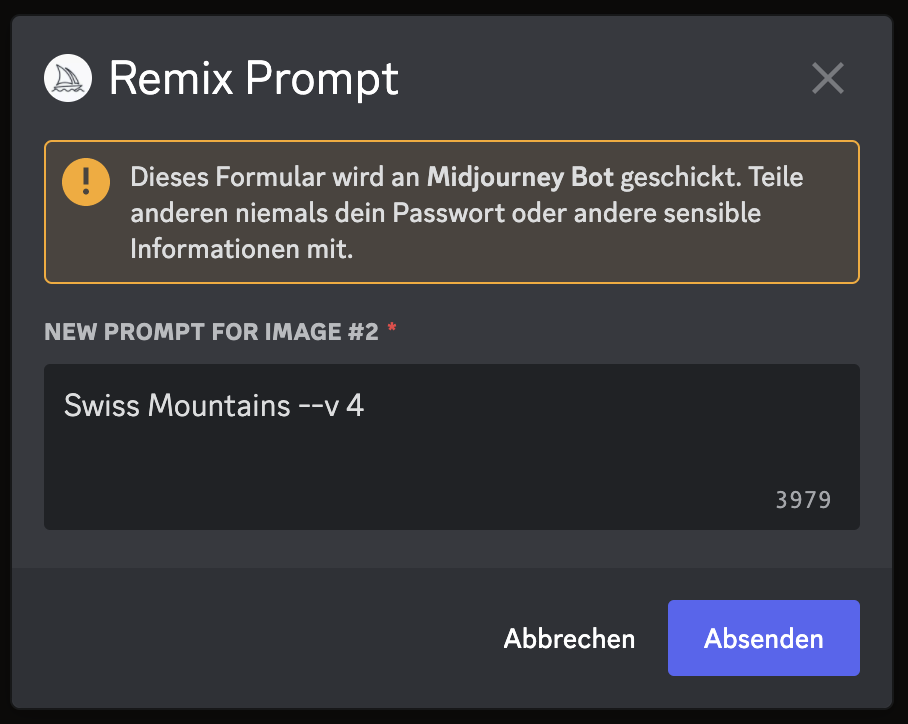

Mit dem Kommando

/settingskann man den Remix-Mode aktivieren (unterste Reihe, Button in der Mitte). Damit erhält man die Möglichkeit, den Prompt bei der Varianten-Wahl (bspw. V2) noch weiter zu spezifizieren oder anzupassen.

Upscale/Vergrössern

Beim Vergössern (kleine Buttons U1-4) werden dem Bildes weitere Details hinzugefügt; es wird quasi final ausgearbeitet. Es gibt verschiedene Upscale-Algorithmen. Upscale Light kann gerade im Bezug auf Hautbeschaffenheit bei Portraits eine mögliche Alternative darstellen.

Am besten, ihr probiert an einem Bild mal verschiedene Vergrösserungs-Versionen aus.

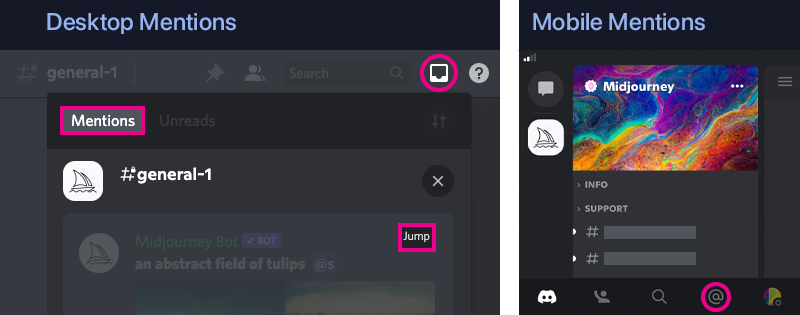

Lost in Discord Information?

In den Midjourney Kanälen ist immer viel los und es passiert schnell, dass man seine Bilder im Nachrichtenstrom „verliert“. Hier hilft das „Mentions“ Postfach, welches sich oben rechts befindet. Dieses zeigt alle eigenen Tasks an.

Sobald man ein Midjourney Abo gelöst hat, besteht auch die Möglichkeit, via Direct Message mit dem Midjourney Bot zu kommunizieren oder gratis einen eigenen Discord Kanal anzulegen und den MJ-Bot da hinzuzufügen. So erhält man einen eigenen Workspace und geht nicht in der Flut von Newbie-Prompts unter. Hier gibt es die Anleitung dazu in der Midjourney Dokumentation.

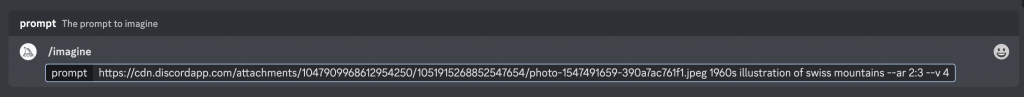

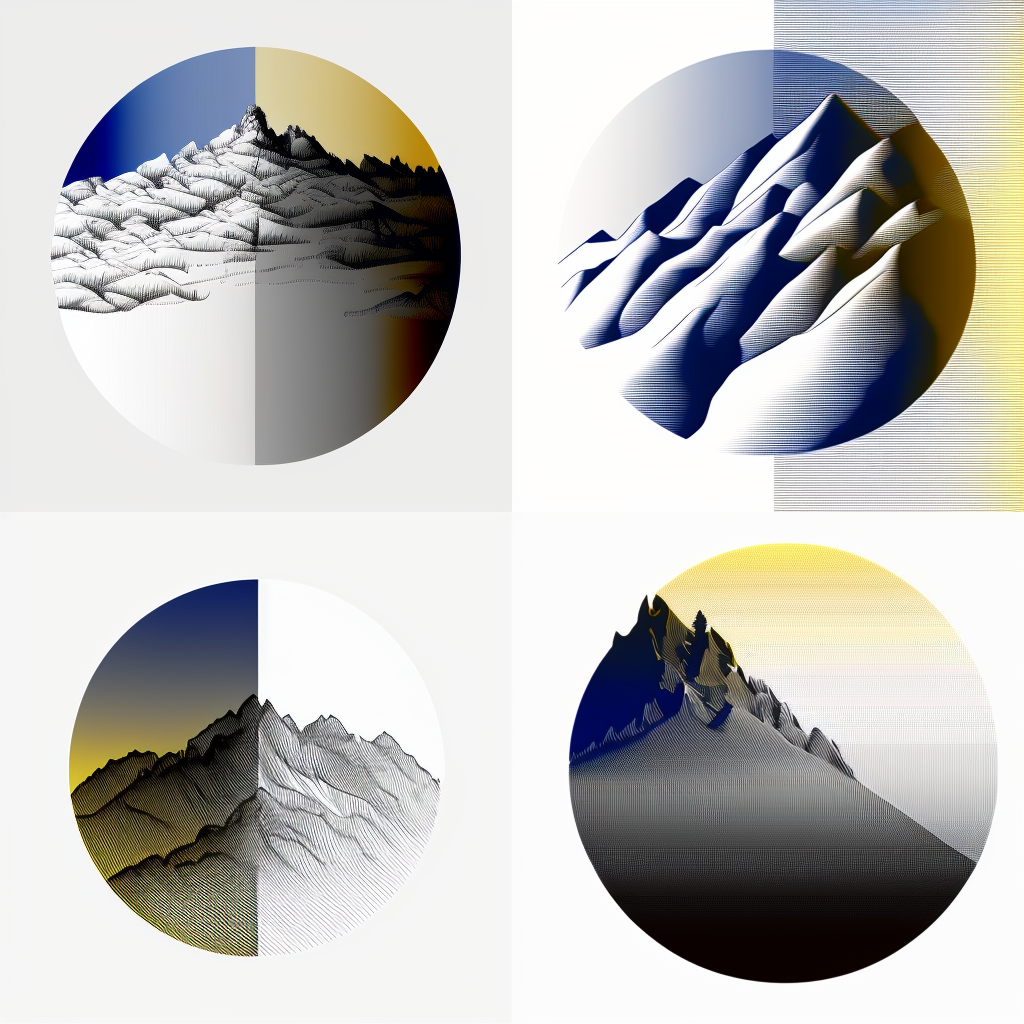

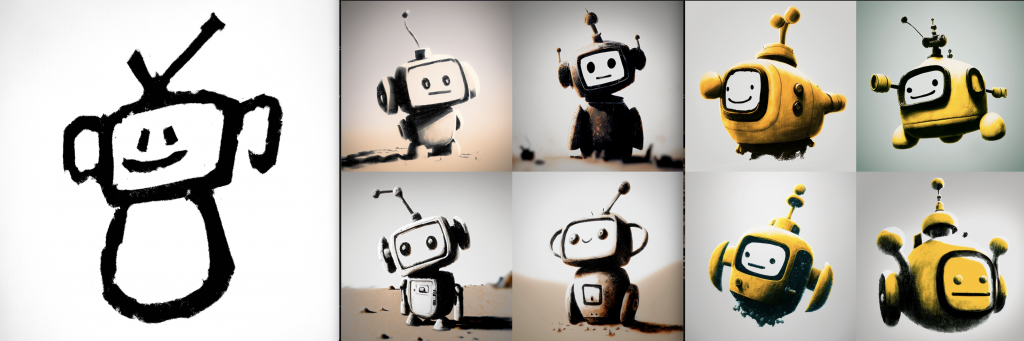

Bilder-Prompts

Neben Text-Inputs kann die KI auch mit Bildern gebrieft werden. Dazu muss die URL des Bild in das Prompt-Feld kopiert werden und dazu zusätzlich ein Wort oder kurzer Text dazu ergänzt werden.

Bei Bildern musst du darauf achten, keine bestehenden Copyrights zu verletzen. Frei verfügbare Bilder gibt es auf Seiten wie Unsplash oder Pexels.

Möchtest du eigene Bilder verwenden, musst du diese zunächst in den Discord Channel hochladen (mit dem kleinen Plus Symbol in der Discord Eingabeleiste). Danach kannst du mit gedrückter rechter Maustaste den Medienlink kopieren. Sind deine Bilder bereits irgendwo online, kannst du einfach diese Bild URL kopieren.

/imagine[ BildURL 1960 illustration of swiss mountains ]

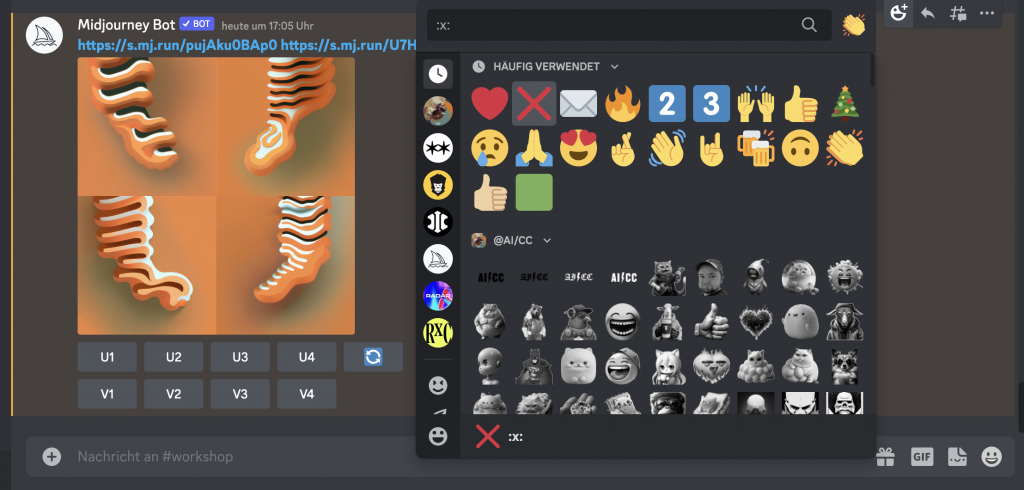

Da die Midjourney Discord Kanäle öffentlich zugänglich sind, empfehle ich, die eigenen hochgeladenen Bilder wieder zu löschen. Dies geht am einfachsten über das Discord Postfach. Da sind unter „Mentions“ die eigenen Bilder aufgelistet. Spring zum Post, den du löschen willst und wähle oben rechts bei „Reaktion hinzufügen“ das grosse rote X. Schon ist es gelöscht. Falls du das X Emoji nicht auf Anhieb findest, gib :x: in die Emojisuchleiste ein.

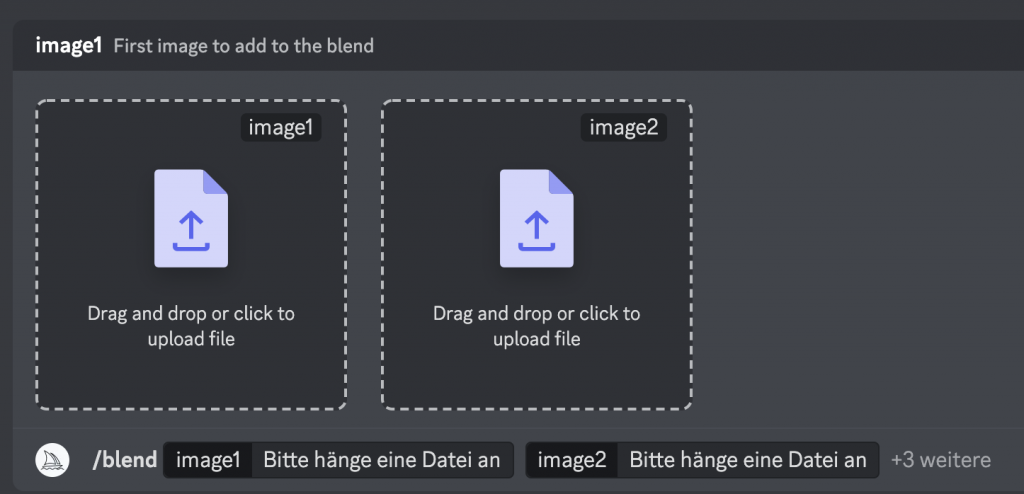

/blend

Update vom 16.01.23: Midjourney hat jetzt das neue /blend Kommando, dass es ganz einfach macht, Bilder zusammen zu morphen. Bis zu 5 Bilder können jetzt mit einem Klick hochgeladen werden.

/blend

Zusätzliche Parameter

Ergänzend zu den Text oder Bilder-Prompts ist es möglich, verschiedene Parameter vorzugeben, welche den maschinengenerierten Output massgeblich beeinflussen können.

Wichtig bei der Eingabe: nach dem jeweiligen Parameter-Kürzel einen Leerschlag eingeben und dann die Zahlenangabe.

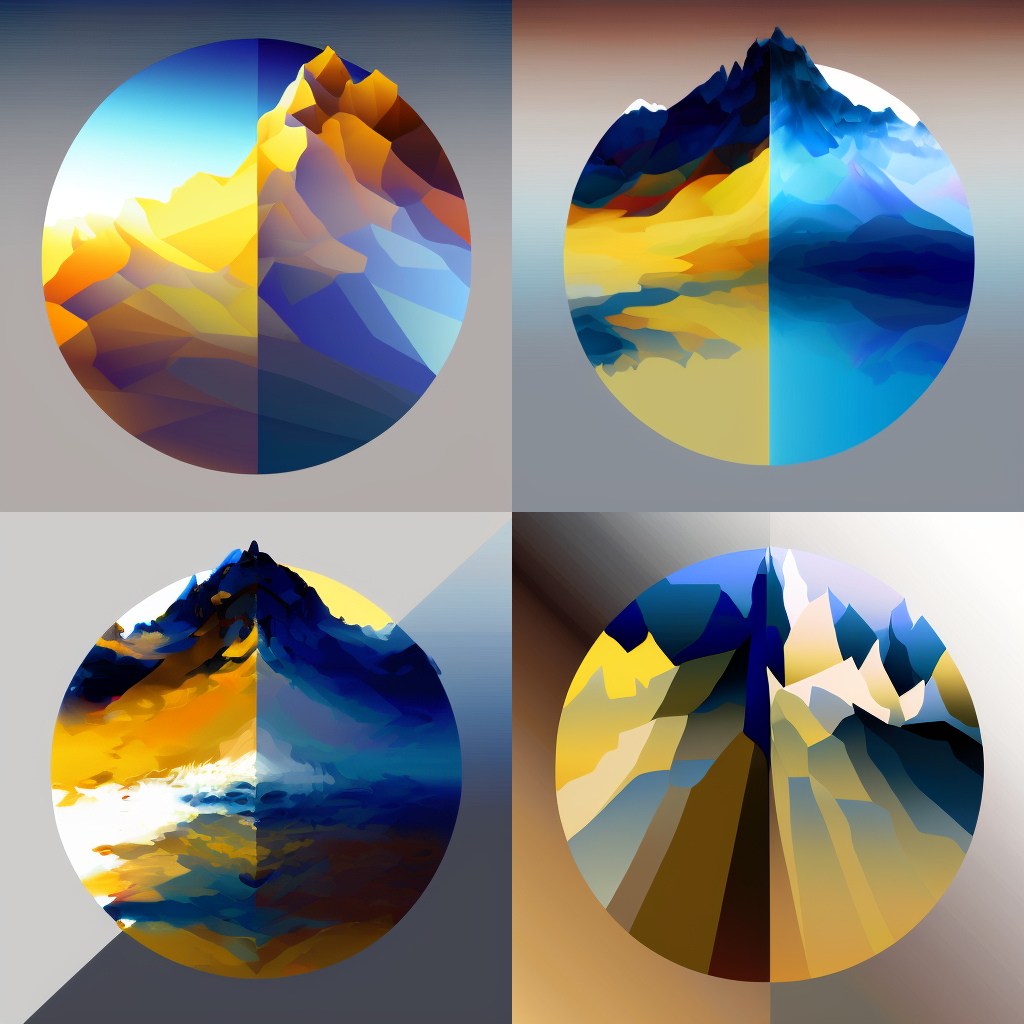

Midjourney Bot Version

Aktuell ist die Midjourney Version V4 automatisch voreingestellt. Diese generiert eher fotorealistische Bilder. Willst du mit einem mehr malerischen Look experimentieren, wähle als Input Parameter die ältere Version V3, oder sogar V2 oder V1.

/imagine[ --v 3 ]

Aspect Ratio (Seitenverhältnis)

Standardmässig ist der Midjourney Output im Verhältnis 1:1, also ein Quadrat. Möchtest du ein Hoch- oder Querformat, ergänze deinen Prompt mit dem Kürzel –ar 2:3 oder –ar 3:2

Bei Nutzung der Midjourney V3 kann auch –ar 9:16 oder –ar 16:9 gewählt werden

/imagine[ --ar 2:3 ]

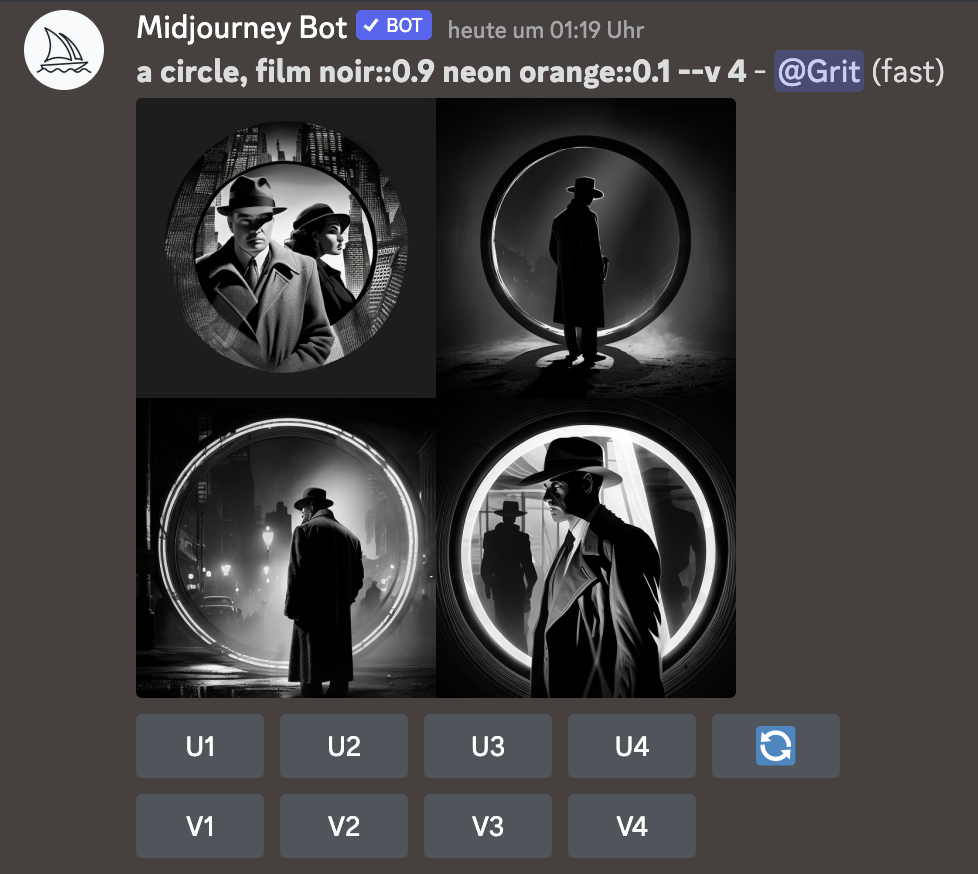

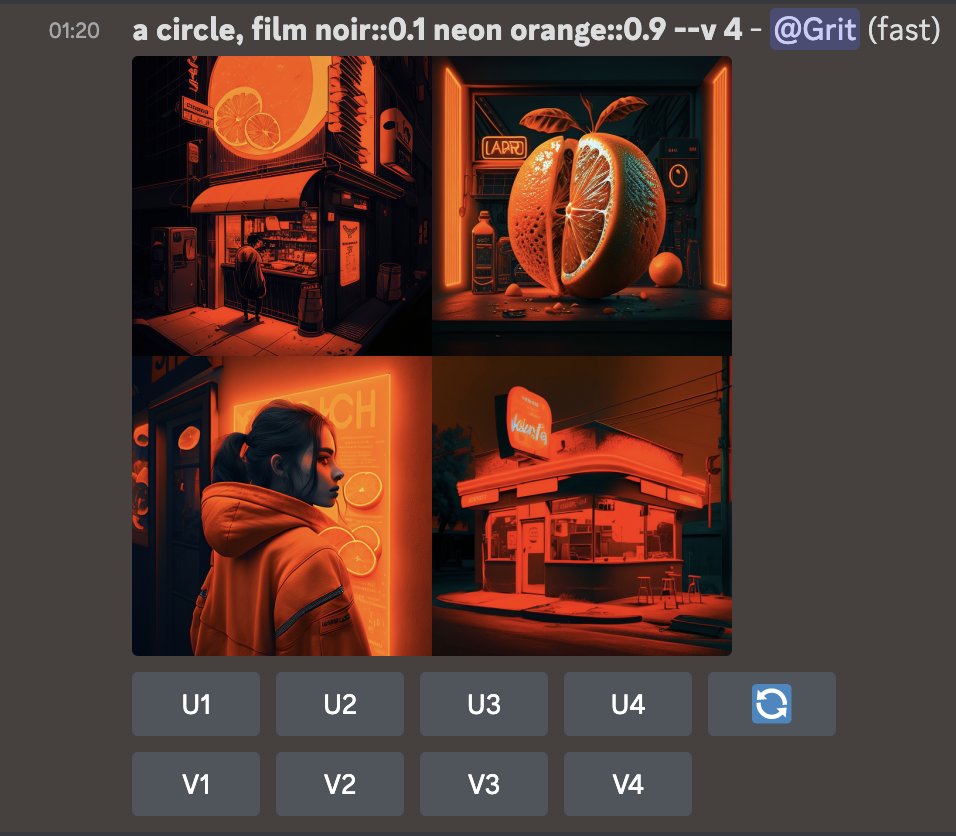

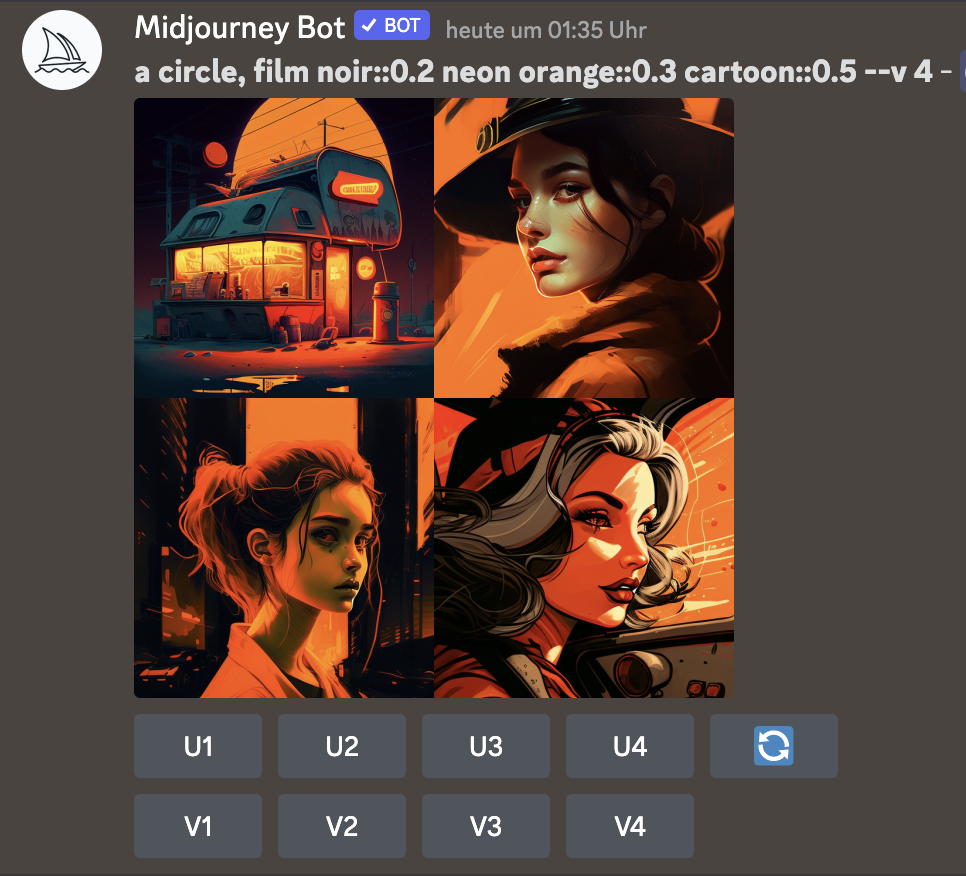

Prompt Weight (Gewichtung von Inputs)

Eine spannende Möglichkeit, den KI Output zu beeinflussen, ist es, die Textinputs zu gewichten. Egal ob 2 verschiedene Sytlebeschriebe oder mehr – die Summe der Gewichtung muss am Ende immer 1 ergeben. Wichtig: im Gegensatz zu den anderen Parametern kommt hier der doppelte Doppelpunkt :: zum Einsatz. Er wird ohne Leerzeichen direkt im Anschluss an den gewünschten Stil geschrieben

/imagine[ Textprompt, erster Stylebeschrieb::0.6 zweiter Stylebeschrieb::0.3 dritter Stylebeschrieb::0.1 ]

Weitere Parameter

–no Hiermit kann man Dinge ausschliessen.

/imagine[ Swiss Mountains --no Snow ]

/imagine[ city --no people ]

/imagine[ Flowers --no red ]–stylize Mit Stylize wird der AI Output detaillierter und komplexer. Auf der Webseite von Andrei Kovalev gibt es viele Anwendungsbeispiele dazu.

/imagine[ Textprompt --stylize 100 ]

Eine komplette Übersicht aller Parameter gibt es auch in der Midjourney Dokumentation.

Fazit: If you can’t beat them, join them.

Ob es allen gefällt oder nicht: Dall-E, Midjourney, Stable Diffusion und Co werden uns in Zukunft begleiten. Auch wenn noch viele – besonders rechtliche Fragen noch offen sind – es lohnt sich schon jetzt, die KI-Werkzeuge kennenzulernen und spielerisch damit zu experimentieren. So entdämonisieren wir die Technik und lernen, was mit KI möglich ist (und was eben auch nicht).

Gerade Kunst- und Kreativschaffende können mit ihrem bereits bestehenden Wissen und ihrer Kreativität die KIs auf überraschende Weise nutzen und so Arbeiten erschaffen, die aus dem visuellen KI-Einheitsbrei herausstechen.

Viel Spass beim Ausprobieren.

Falls ihr noch Fragen, Anmerkungen oder Interesse an einer Wiederholung dieses Workshops habt, schreibt mir.

Grit Wolany arbeitet als Trend Researcherin beim ZHdK Digital Skills& Spaces Programm. Sie studierte an der ZHdK im MA Design, Trends & Identity und schrieb ihre Masterarbeit zum Thema „KI in der Kreativwirtschaft“.